Apache Airflowで実現するデータ分析基盤の自動化と効率化①

Airflowとは?

Apache Airflowは、データパイプラインのスケジューリングと自動化を管理するためのオープンソースプラットフォームです。2014年にAirbnbによって開発され、現在ではApache Software Foundationのプロジェクトとして多くの企業に導入されています。

Airflowは、データパイプラインのタスクを整理し、DAG(Directed Acyclic Graph、非巡回有向グラフ)という形式で管理します。DAGは、タスク同士の依存関係を視覚的に整理し、複雑なワークフローの実行を簡略化するのに役立ちます。

Airflowの強力なポイントは、柔軟性とスケーラビリティです。Pythonで定義されたワークフローは、複数のスケジューリング条件に対応し、クラウドやオンプレミス環境を問わずに実行可能です。また、Airflowはさまざまなタスク実行オペレーターを持っており、データベース、ストレージ、外部APIとの統合をスムーズに行うことができます。

主な特徴:

- Pythonベース: ワークフロー定義はPythonで記述し、非常に柔軟なタスクの制御が可能。

- DAGによる管理: 複雑なタスク間の依存関係をDAG形式で表現。

- プラグイン可能なアーキテクチャ: 外部サービスやカスタムタスクを簡単に統合できる。

- スケーラブル: Celery ExecutorやKubernetes Executorを使うことで、分散環境で並列にタスクを実行できる。

なぜAirflowがデータ分析基盤に必要なのか?

最新のデータ分析基盤では、大量のデータを定期的に処理し、さまざまなデータソースを統合してインサイトを得る必要があります。しかし、データパイプラインの手動管理には限界があります。手動でのジョブ実行やスケジュール設定は、ミスの原因となり、プロジェクト全体の効率が低下する可能性があります。ここで、Airflowのようなワークフロー自動化ツールが力を発揮します。

Airflowが解決する課題

タスクの自動実行:

Airflowを使えば、スケジュールに従ってデータの収集、変換、ロード(ETL)を自動化できます。これにより、パイプラインの安定性が向上し、データ処理のミスが減少します。

複雑な依存関係の管理

多くのデータパイプラインでは、処理順序や依存関係が複雑です。例えば、あるデータ処理が完了した後に別の処理を実行する必要がある場合でも、Airflowならタスクの依存関係を定義するだけで自動的に管理されます。

エラーハンドリングとリカバリ

パイプラインでエラーが発生した場合、Airflowはタスクレベルでエラーを検知し、再実行のポリシーを設定できます。これにより、処理が中断するリスクを最小限に抑えます。

導入のメリット

Airflowの基本機能

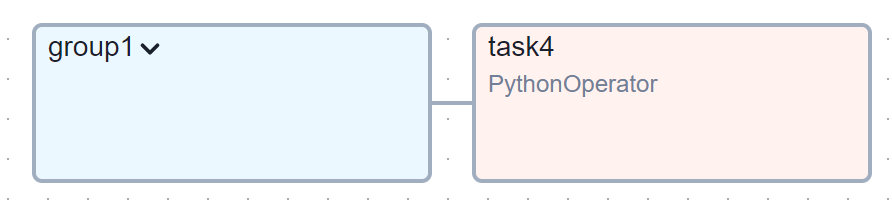

Airflowの基礎は「DAG(Directed Acyclic Graph)」です。DAGは、一連のタスクを非巡回有向グラフの形で表現し、それぞれのタスクがどの順番で実行されるかを示します。DAGを作成するとき、依存関係に従って各タスクが実行され、Airflowが自動的にタスクのスケジューリングや並列実行を管理します。

DAG(Directed Acyclic Graph)

スケジュール設定

最新のAirflowでは、DAGのスケジュールを柔軟に設定することができます。たとえば、式やAirflowの便利なスケジュールプリセット(例: , , )を使って定期的な実行を設定できます。加えて、に加えて、パラメータもサポートされており、特定のスケジューリングをより直感的に設定することが可能です。

タスクの依存関係

タスク同士の依存関係は、従来通り演算子を使って指定できます。また、最新バージョンでは関数を使用することで、複数のタスクを簡潔に直列や並列で設定できるようになっています。これにより、複雑な依存関係もシンプルに定義でき、ワークフロー全体の構造をより視覚的に管理することが可能です。

タスクオペレーター

Airflowには、さまざまなタイプのオペレーターがあり、これらを使ってDAG内のタスクを実行します。代表的なオペレーターは以下の通りです。

- PythonOperator: Python関数を実行するオペレーター。ETLプロセスのデータ変換や分析に活用されます。

- BashOperator: シェルコマンドを実行するオペレーター。スクリプト実行や外部プログラムの呼び出しに便利です。

- BigQueryOperator: BigQueryのクエリを実行するオペレーター。クラウドベースのデータ分析に最適です。

センサー

Airflowには、タスクが特定の条件を満たすまで待機するための「センサー」もあります。例えば、特定のファイルがS3バケットに存在することを確認してから次のタスクを実行することができます。

- S3KeySensor: S3バケットに特定のファイルが存在するかをチェックするセンサー。

- ExternalTaskSensor: 他のDAGのタスクが完了するまで待機するセンサー。

並列実行とキュー管理

Airflowは並列タスク実行をサポートしており、CeleryやKubernetesなどのエグゼキューターを使用してスケーラブルなタスク処理が可能です。これにより、膨大なデータ処理や複数のワークフローを同時に実行できます。

次回、「Apache Airflowで実現するデータ分析基盤の自動化と効率化②」に続きます。